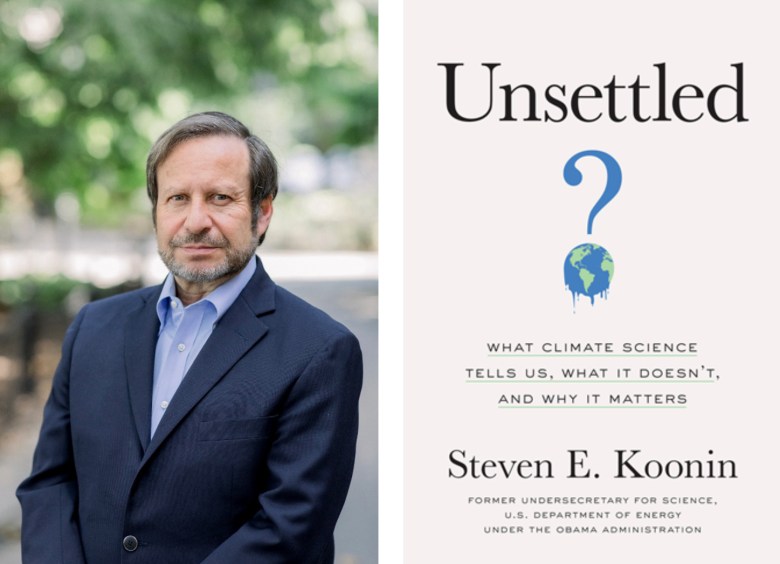

O texto que se segue baseia-se no livro de Steven E. Koonin, Unsettled – What Climate Science Tell Us, What it Doesn’t, and why it Matters, publicado em abril de 2021 (ainda não editado em Portugal) e, em linha com os restantes artigos da categoria “Livros”, é uma síntese deste importante e extremamente atual ensaio científico, contendo, em algumas passagens, citações literais (traduzidas por nós), não podendo, em consequência, ser considerado um texto crítico, antes um artigo de divulgação. Os títulos dos capítulos que se seguem são, inclusive, literalmente transpostos desta obra de Steven Koonin, um físico teórico do Caltech, especialista em clima e energia, e um dos mais conceituados cientistas americanos. Mãos à obra.

**************************************************

Introdução

Apesar de ser verdade que o globo está numa fase de aquecimento, e que os humanos têm alguma influência nisso, sobretudo através da queima de combustíveis fósseis, não é possível confirmar cientificamente, antes pelo contrário, as notícias alarmistas que os media veiculam quase todos os dias, anunciando um desastre ecológico. A ciência climática envolve muitos campos científicos diferentes, abrangendo a física quântica das moléculas; a física clássica do ar em movimento, água e gelo; os processos químicos na atmosfera e nos oceanos; a geologia da terra sólida; e a biologia dos ecossistemas. O estudo climático também comporta o uso de tecnologias sofisticadas, incluindo a criação de modelos nos computadores mais rápidos do mundo, controlo remoto de satélites, análise paleoclimática (que estuda os climas antigos), e métodos estatísticos avançados. Finalmente, temos ainda as áreas relacionadas com a ciência climática – política, economia, e tecnologia energética – focadas na redução das emissões de gases com efeito de estufa. Este enorme leque de conhecimentos e metodologias fazem da ciência climática e energética a mais avançada, e também a mais complexa, atividade científica multidisciplinar.

As mais importantes avaliações sobre o clima vêm dos relatórios produzidos pelo Painel Intergovernamental para as Alterações Climáticas (IPCC – Intergovernmental Panel on Climate Change) das Nações Unidas, criado em 1988. O IPCC (manteremos ao longo do artigo os acrónimos em inglês) produziu o seu primeiro relatório de avaliação em 1990; o quarto relatório (denominado AR4) foi emitido em 2007; o quinto (AR5) em 2013, e o sexto (AR6) em 2021.1 O setor fundamental na elaboração de cada relatório é o chamado “Grupo de Trabalho I” (WG I), que lida com os aspetos físicos do sistema climático, particularmente as alterações observadas em décadas recentes, e com a forma como o clima responde às influências naturais e humanas. Outros grupos de trabalho baseiam-se nas avaliações do WG I para descrever os impactos de um clima em mudança e a resposta da sociedade a esses impactos. Cada grupo de trabalho prepara também um Resumo para Decisores Políticos (SPM – Summary for Policymakers); uma síntese de todos os setores é também publicada. Além da série de relatórios de avaliação (AR), o IPCC também publica relatórios especiais mais restritos, como sejam “Eventos Extremos”2, “O Oceano e a Criosfera”3, ou “Alterações Climáticas e Terra”4.

| Expressão | Probabilidade |

| Virtualmente certo (Virtually certain) | 99-100% de probabilidade |

| Muito provável (Very likely) | 90-100% de probabilidade |

| Provável (Likely) | 66-100% de probabilidade |

| Tão provável como não provável (About as likely as not) | 33-66% de probabilidade |

| Improvável (Unlikely) | 0-33% de probabilidade |

| Muito improvável (Very unlikely) | 0-10% de probabilidade |

| Excecionalmente improvável (Exceptionally unlikely) | 0-1% de probabilidade |

O governo dos Estados Unidos também emite, independentemente, a sua série de relatórios de avaliação. A Lei de Pesquisa sobre Alterações Globais, de 1990, requer uma Avaliação Climática Nacional (NCA – National Climate Assessment) a cada quatro anos. Esses relatórios são produzidos pelo Programa de Pesquisa sobre Alterações Climáticas dos Estados Unidos (USGCRP)5. Os relatórios da NCA têm, em larga medida, os mesmos propósitos dos ARs do IPCC, embora com um foco maior sobre os Estados Unidos. O conteúdo das NCAs alinha-se, geralmente, com o dos ARs, mas podem ocorrer diferenças de ênfase e linguagem. As três primeiras NCAs foram publicadas em 2000, 2009 e 2014. A quarta, NCA 2014, compreende dois volumes. O volume I, focado na ciência climática física, foi publicado em novembro de 2017, tal como o “Relatório Especial sobre Ciência Climática” (CSSR – Climate Science Special Report)6. O volume II, publicado em novembro de 2018, trata dos impactos e riscos de um clima em mudança, bem como da forma como nos podemos adaptar a essas mudanças7. A quinta NCA é esperada em 2023.

Os AR e NCA são desenhados e revistos por processos semelhantes. A entidade patrocinadora (o IPCC ou o USGCRP) seleciona equipas de especialistas para cada capítulo dos relatórios. Essas equipas produzem esboços sucessivos que são melhorados em resposta a comentários de outros peritos; a NCA também se submete a uma revisão formal levada a cabo por um painel convencionado pelas academias nacionais americanas. O processo completo demora anos. Por exemplo, a primeira reunião dos autores responsáveis pelo AR6 teve lugar em junho de 2018, cerca de três anos antes da data prevista para publicação do relatório. Os relatórios de avaliação apresentam a ciência a não especialistas. Dada a quantidade enorme de autores e de revisões, qualquer leitor poderá, naturalmente, esperar que os relatórios de avaliação e os resumos da literatura de pesquisa são completos, objetivos, e transparentes – o “padrão ouro”. De acordo com Koonin, os relatórios vão de encontro a essa expectativa, e o próprio livro que Koonin escreveu é, em grande parte, baseado neles. Mas uma leitura atenta da maioria dos mais recentes relatórios de avaliação também revela algumas falhas elementares que enganam ou desinformam os leitores em pontos importantes. Quais são essas falhas, como surgiram, como os media as aceitam e divulgam, e o que pode ser feito para as corrigir constitui uma outra dimensão da história da ciência, que importa contar.

Isto mostra que as coisas são bastante mais complexas do que geralmente se pensa. Há, por exemplo, algumas conclusões retiradas dos relatórios de avaliação, quer os das agências governamentais dos Estados Unidos, quer os do IPCC que poderão surpreender muitas pessoas, e que contrariam as manchetes alarmantes e sensacionalistas que quotidianamente vemos na comunicação social. Eis algumas delas.

- As ondas de calor nos Estados Unidos não são mais comuns agora do que eram em 1900.

- As temperaturas mais elevadas não subiram nos últimos 50 anos nos Estados Unidos.

- Os seres humanos não tiveram impacte detectável sobre os furacões nos últimos cem anos.

- O lençol de gelo da Gronelândia não está a encolher, hoje, mais rapidamente do que há 80 anos.

- O impacte económico global das alterações climáticas induzidas pelo homem será mínimo, pelo menos até ao final deste século.

1- O que se sabe sobre o aquecimento

Uma vez que o clima é definido por médias relativas a muitos anos, ele muda gradual e lentamente. É necessário, pelo menos, uma década de dados para se definir um clima, e duas ou três décadas mais para identificar uma mudança. Isto está, muitas vezes, para além da memória humana e, por isso, precisamos de registos para não nos equivocarmos. Porém, o que conquista a atenção popular são os eventos extremos, como tempestades e ondas de calor, embora o seu número e intensidade variem de ano para ano e seja a sua média, extraída ao longo de décadas, o que define o clima. A tendência de subida da temperatura tem causas diversas. Uma delas relaciona-se com a) a variabilidade interna do sistema climático – fluxos e refluxos durante décadas, maioritariamente associados às correntes lentas dos oceanos; depois, há b) os fenómenos naturais, como mudanças na luminosidade solar, que forçam (influenciam), por sua vez, mudanças no sistema climático; e, finalmente, de grande interesse para nós, há c) as mudanças e tendências que podem ocorrer devido às atividades humanas.

É de realçar que o termo “alterações climáticas” induz a muitas confusões. A convenção-quadro das Nações Unidas define assim “alterações climáticas”: … uma mudança no clima, atribuída direta ou indiretamente à atividade humana, que altera a composição da atmosfera ao nível global, a qual, em conjunto com a variabilidade natural observada durante períodos comparáveis…8

Esta definição exclui explicitamente as alterações devidas a causas naturais e consubstancia, hoje, o entendimento comum sobre o termo. Desta forma, quando as pessoas ouvem falar de “alterações climáticas”, assumem que se trata de alterações provocadas pelo homem. Paradoxalmente, ou não, a Terra arrefeceu um pouco entre 1940 e 1980, embora a atividade humana tenha aumentado, e é por isso vital perceber porque isso aconteceu, para percebermos também qual é efetivamente a influência humana e que mudanças poderão ocorrer no futuro. Por outro lado, o aquecimento global nos últimos 40 anos não é uniforme. A superfície terrestre aquece mais rapidamente que a superfície dos oceanos e as altas latitudes perto dos polos estão a aquecer mais rapidamente que as baixas latitudes perto do equador. Em geral, as temperaturas mais frias (à noite, durante o inverno, etc.) estão a subir mais rapidamente que as temperaturas mais quentes – o clima está ficando mais suave à medida que o globo aquece.

É claro que há outras coisas importantes para o clima, para além das mudanças de temperatura na superfície ou mesmo mudanças na atmosfera. De facto, a atmosfera é uma parte relativamente menor de um muito maior e mais complexo sistema que inclui a água (oceanos, lagos, etc.), neve e gelo, em terra e no mar, a terra sólida, e coisas vivas (micróbios, plantas, animais e humanos). Os oceanos, cuja profundidade média é de 3.700 metros, são a parte mais importante e mais problemática do sistema climático da Terra. Eles detêm mais de 90% do calor climático e são a sua memória de longo prazo. As condições na atmosfera variam, de dia para dia e de ano para ano, em resposta a um grande número de influências. Os oceanos, por seu turno, mudam, e respondem a mudanças, em décadas ou séculos.

Não é fácil recolher dados úteis dos oceanos para avaliar as alterações climáticas, mas a situação melhorou muito a partir do ano 2000, com a criação do programa Argo9 – robôs à deriva nos oceanos para registarem as suas propriedades – que atingiu cobertura global em 2005, com cerca de 3500 em atividade, operando a 1 km de profundidade, mas descendo de 10 em 10 dias a 2 km, para medirem a temperatura e a salinidade, subindo depois à superfície para transmitirem os dados via satélite, antes de regressarem à sua posição normal a 1 km de profundidade. Apesar da dificuldade em recolher dados nos oceanos antes do Argo, é possível dizer que, de facto, os oceanos têm vindo a aquecer, embora muito modestamente (centésimas de grau por década), logo, o planeta também. É difícil, porém, avaliar a influência humana nesta tendência, uma vez que a subida é constante, mesmo em épocas de menor atividade humana, como sejam os anos entre 1921 e 1946.

Há 20 mil anos a Terra começou a aquecer (cerca de 5º) o que permitiu, desde há 10 mil anos, um rápido desenvolvimento da civilização. Desde há milhões de anos, a Terra alterna períodos de rápido aquecimento com períodos de lento arrefecimento. Estas variações são devidas a pequenas alterações da órbita da Terra em torno do Sol e na inclinação do eixo terrestre. O mais recente período de aquecimento, antes do atual, começou há cerca de 127 mil anos e durou 20 mil anos. Nessa altura a superfície terrestre era até 2º-3º mais quente do que é hoje. Em suma, a questão não é a de saber se a Terra está a aquecer – o que é afirmativo – mas saber qual a influência que os humanos têm nesse aquecimento – o que é difícil de avaliar.

Fraca Influência Humana

A temperatura da Terra resulta do balanço entre o aquecimento devido à luz solar e o arrefecimento derivado do calor irradiado para o espaço. Do lado do aquecimento temos a energia solar que o planeta absorve. À medida que aquece, a Terra emite radiação infravermelha para o espaço, o que aumenta a parte de arrefecimento do balanço. A lei Stefan-Boltzmann, descoberta por volta de 1880 por dois físicos a trabalhar na Áustria, diz-nos que a quantidade de radiação infravermelha que um objeto emite aumenta com a temperatura, de uma forma proporcional e bastante precisa. Assim, à medida que a temperatura do planeta aumenta devido ao aquecimento solar, o arrefecimento devido à radiação infravermelha emitida também aumenta, até o arrefecimento infravermelho ser igual ao aquecimento solar. O termo técnico para esta condição goldilock – quando o planeta não ganha nem perde energia e a sua temperatura é estável – é radiative equilibrium.

Olhemos mais atentamente para ambos os lados deste balanço. Uma vez que a Terra não é completamente negra, ela absorve apenas 70% da luz solar que a atinge. Aos 30% refletidos chama-se albedo, (do latim albus, que quer dizer “branco”). Quando o albedo é mais elevado, a Terra reflete mais luz solar e por isso fica um pouco mais fria e, claro, quando o albedo é mais fraco, a Terra absorve mais luz solar e, logo, fica mais quente. Apesar da média do albedo terrestre ser de 30%, o valor do mesmo num determinado momento depende de que parte da planeta está virada para o Sol (os oceanos são escuros, a parte terrestre é mais brilhante, as nuvens mais brilhantes ainda, e a neve e o gelo são ainda mais brilhantes), e a média mensal varia cerca de 0,01 com as estações (maior em março e menor em junho/julho). A precisão com que se mede o albedo é importante para compreendermos o sistema climático. Se o albedo médio aumentasse de 0,30 para 0,31, devido, por exemplo, a um aumento de 5% da nebulosidade, essa reflexividade adicional compensaria largamente a influência de um aumento para o dobro do CO2 presente na atmosfera.

Existem satélites que medem o albedo, mas há um projeto da JASON que pretende cobrir todo o globo com pequenos satélites para que se consiga medir o albedo com maior precisão. Um método mais antigo, mas ainda assim muito interessante, foi usado por André Danjou, um astrónomo francês, no início dos anos de 1930. Consistia em, através de um filtro apropriado, detetar o brilho da luz solar que incide na Terra, refletida na parte escura da Lua, quando esta está em quarto crescente. Compreender as mudanças da luz, refletida da Terra, na Lua pode ser muito útil para estudar outros planetas que orbitam outras estrelas, os quais são visíveis pela luz que refletem.10

Conhecendo o albedo da Terra (a média do globo e os ciclos diários e sazonais), poderemos determinar o seu equilíbrio de temperatura, através do balanço entre a luz solar absorvida contra o arrefecimento dos infravermelhos. Como vimos, o arrefecimento aumenta ao mesmo tempo que a temperatura aumenta – se a Terra ficar mais quente, os infravermelhos libertam mais calor – funcionando como uma espécie de termostato. Calcular o valor deste equilíbrio – a temperatura média da superfície terrestre – constitui o problema básico de qualquer curso sério dedicado ao clima. Esse valor é de -18ºC (0ºF). Mas este valor está errado, muito abaixo de verdadeiro valor médio global de temperatura, que é de 15ºC (59ºF). O que falta é o isolamento provocado pelos gases com efeito de estufa presentes na atmosfera, os quais fazem subir a temperatura da superfície terrestre para o valor observado. Os gases com efeito de estufa funcionam como as roupas isolantes que os exploradores dos polos terrestres usam. Impedem o calor de sair, e os infravermelhos são impedidos de viajar para o espaço.

Os gases mais comuns presentes na atmosfera terrestre são o nitrogénio (78%) e o oxigénio (21%). Juntos, eles constituem, portanto, 99% da atmosfera seca, e devido às peculiaridades das suas estruturas moleculares, o calor passa facilmente através deles. A maior parte do restante 1% é o gás inerte árgon. Mas, embora ainda menos abundantes, alguns dos outros gases – sendo os mais significativos o vapor de água, o dióxido de carbono, o metano, o óxido nitroso e o ozono – intercetam, em média, cerca de 83% do calor emitido pela superfície terrestre11. Destes gases, o que mais contribui para o efeito de estufa é o vapor de água (+ de 90%), depois, o dióxido de carbono (7%) e, finalmente, todos juntos, metano ozono e óxido nitroso, entre outros, com mais ou menos 3%.

Desde 1750, a concentração de dióxido de carbono aumentou de 0.000280 ppm (partes por milhão) até 0.000410 ppm em 2019, continuando a crescer 2.3 ppm a cada ano. Embora a maior parte da concentração de CO2 seja natural, não há dúvida de que este crescimento resulta da atividade humana, sobretudo da queima de combustíveis fósseis. O aumento de CO2 faz com que o efeito de estufa seja maior e a fração de calor intercetado, que era em 1750 de 82,1%, é hoje de 82,7%. Se duplicássemos a concentração de CO2 de 1750, que como vimos era de 280 ppm, isso resultaria numa concentração de 560ppm, a qual aumentaria a capacidade de interceção do calor para 83,2% (isto em condições de céu limpo, porque as humidade, temperatura, nebulosidade, entre outras, têm influência sobre o calor intercetado). Um tal aumento corresponderia apenas a um incremento de 2,8 moléculas de CO2 por 10 mil moléculas de ar.

A primeira questão que aqui se coloca é a de saber como é que um aumento de menos de 3 moléculas em 10.000, ou seja, um aumento de apenas 0,03%, provoca um aumento 30 vezes maior (1%) na interceção do calor libertado pela Terra em forma de radiação infravermelha. Isto acontece porque a radiação é emitida e dispersada em diferentes comprimentos de onda. Pensemos nestes comprimentos de onda como “cores”, embora não captáveis pelos nossos olhos. O vapor de água, o mais importante gás para o efeito de estufa, interceta apenas algumas cores, mas porque bloqueia quase cem por cento destas, acrescentar mais vapor de água à atmosfera não tornará o isolamento mais forte – seria como acrescentar uma camada a uma janela já pintada de preto. Mas isto não acontece com o dióxido de carbono. Esta molécula interceta algumas cores que o vapor de água não atinge, o que quer dizer que poucas moléculas de CO2 podem ter um efeito muito maior (como uma primeira demão de preto numa janela não pintada).

No entanto, embora o efeito da concentração atual de CO2 seja importante (7,6%), a sua duplicação não altera substancialmente as coisas (um aumento de 0,8%) devido ao efeito de “pintar uma janela preta”, já referido. Isto leva-nos à segunda questão. Porque é que um aumento tão modesto, de cerca de 1%, pode ter tanta importância? Acontece que os modelos do IPPC nos dizem que a duplicação dos níveis de CO2 desde os tempos pré-industriais – causando a mudança de 1% na interceção do calor, já discutida atrás – deve aumentar a temperatura da superfície terrestre em cerca de 3ºC (5,5ºF). Uma vez que a temperatura média da superfície terrestre é de 15ºC (59ºF), um aumento de 3ºC representa um aumento de 20% (3ºC em 15ºC). Mas, na escala Fahrenheit, esta mudança é de 5,5ºF, retirada da média de 59ºF, um aumento de 10%. Ora, porque é que a percentagem de subida da temperatura depende da escala que usamos? Como pode uma subida de 1% na captura de calor produzir um tal efeito colateral?

O problema está mesmo na escala que usamos, seja a de Celsius ou a de Fahrenheit, ambas adstritas às propriedades da água – que gela a 0ºC (32ºF) e ferve a 100ºC (212ºF). Ora, a lei Stefan- Boltzmann que, como vimos, descreve a relação entre o calor irradiado pela Terra e a sua temperatura, baseia-se em temperaturas absolutas, que são medidas pela escala de Kelvin, adstrita ao zero absoluto – a temperatura em que a matéria está tão fria que não emite qualquer calor (0K = -273,15ºC ou 459,67ºF). Assim, a temperatura média da superfície terrestre é de 15ºC (59ºF) a que correspondem 288K. A uma subida de 3ºC (5,5ºF) corresponde uma subida de 3K (as escalas Celsius e Kelvin têm intervalos iguais), o que, sobre 288, dá o valor correto de 1% na capacidade de a atmosfera intercetar o calor quando a concentração de CO2 é duplicada. Deste modo, na escala apropriada, a influência humana revela-se muito modesta.

Mas nem todas as influências humanas provocam aquecimento. Os aerossóis, por exemplo, são finas partículas na atmosfera que refletem a luz solar e formam nuvens refletivas. Juntamente com alterações nos terrenos, com a desflorestação (pastagens são mais refletivas que florestas) aumentam o albedo e exercem uma influência para o arrefecimento que anula cerca de metade do aquecimento provocado pelos gases com efeito de estufa. Causas naturais, como os vulcões, que lançam aerossóis para a atmosfera, onde podem permanecer durante vários anos, também contribuem para o arrefecimento. Mudanças na intensidade solar (originadas pela sua variabilidade interna) podem também alterar a quantidade de luz solar que atinge a Terra. Tudo isto torna complicado avaliar as dimensões natural e humana no que diz respeito ao delicado equilíbrio energético do planeta. A maior influência humana sobre o sistema climático prende-se com a emissão de gases com efeito de estufa. Mas a relação entre essa emissão e a influência que ela tem no clima é mais complicada do que se poderia imaginar.

Emissões Explicadas e Extrapoladas

Dos gases com efeito de estufa que sofrem influência da atividade humana, os mais importantes são o dióxido de carbono (CO2) e o metano (CH4). Apesar do nosso foco estar centrado na redução de emissões, a correspondência entre concentração e emissão não está, de forma alguma, bem estabelecida. A emissão de CO2 pelos humanos é modesta, no contexto do ciclo natural de carbono que se move sobre a crosta terrestre – oceanos, plantas e atmosfera. Como veremos, o aumento de CO2 provocado pelo homem aumentará, sob qualquer cenário, durante décadas. Mas, apesar da precisão reclamada pelos modelos climáticos, o seu impacto é largamente incerto.

Comecemos pelo princípio. A Terra foi formada há 4,5 mil milhões de anos, com uma dotação fixa de carbono. Esse carbono encontra-se hoje em diversos locais no planeta, nos chamados “reservatórios”. O maior reservatório é de longe a crosta terrestre, que contém quase todo o carbono do planeta, cerca de 1,9 mil milhões de gigatons (1 gigaton, Gt, são mil milhões de toneladas). A segunda maior quantidade, cerca de 40 mil Gt, está nos oceanos, quase todo abaixo da superfície. Há também cerca de 2.100 Gt armazenados nas terras, solos e coisas vivas, e 5.000-10.000 Gt em combustíveis fósseis debaixo dos fundos terrestres e marinhos. Os 850 Gt de carbono presente na atmosfera, quase todo na forma de dióxido de carbono, corresponde a cerca de 25% do carbono presente na, ou perto da, superfície terrestre (em solos, plantas e oceanos pouco profundos), mas representa apenas 2% do carbono presente nos oceanos.

Poderosos processos naturais movimentam o carbono terrestre entre esses reservatórios, transformando frequentemente a sua fórmula química. O mais importante destes processos é o fluxo sazonal de cerca de 1/4 do carbono da atmosfera para as plantas em crescimento – que usam a fotossíntese para transformar o CO2 da atmosfera em matéria orgânica, que depois regressa à atmosfera através da respiração das plantas e à medida que essa matéria orgânica decai. Outros processos bastante mais lentos transportam o carbono da superfície para as profundezas dos oceanos e depois transformam-no em rochas, tais como calcário e mármore, formadas a partir de conchas de animais marinhos.

O CO2 emitido através da queima de combustíveis fósseis altera o equilíbrio deste grande ciclo anual, uma vez que o carbono é retirado das profundezas dos solos onde estava isolado através deste processo natural. O uso de combustíveis fósseis aumenta em 4,5% o carbono que circula no ciclo anual. Cerca de metade deste aumento é absorvido pela superfície terrestre (a subida de CO2 fez aumentar bastante a vegetação do planeta) e o remanescente fica na atmosfera, aumentando por esta via a concentração de CO2. Há 5 linhas independentes que provam a influência humana no aumento da concentração de CO2 nos últimos 150 anos, por isso nenhum cientista contesta essa influência:

- as concentrações ao longo dos últimos 10 mil anos variaram entre 260 e 280 ppm, antes de uma forte subida ter ocorrido em meados do século XIX.

- esta subida é o que seria expectável pela queima de combustíveis fósseis.

- esta subida é antecipada em 2 anos no hemisfério norte, onde a queima de combustíveis fósseis é maior, relativamente ao hemisfério sul.

- a subida do carbono é de um tipo de carbono “leve” 12C, presente nos seres vivos, cujos restos são, como se sabe, os constituintes dos combustíveis fósseis.

- o oxigénio está a diminuir – embora muito levemente e sem consequências para os humanos – em proporção correspondente ao necessário para transformar o carbono fóssil em CO2.

No entanto, a concentração de CO2 já foi muitíssimo maior do que a que existe hoje. Apenas no período permiano, há 300 milhões de anos, o nível de CO2 era idêntico ao de hoje. De resto, foi sempre muito superior, e apenas há cerca de 175 milhões de anos começou a decrescer até ao século XIX. Nessa altura, em que os níveis de CO2 eram cinco ou dez vezes superiores aos de hoje, a vida de plantas e animais era florescente. Mas eram animais e plantas diferentes. A vida na Terra está agora adaptada a baixos níveis de CO2. O dióxido de carbono é o único gás com efeito de estufa provocado pelo homem com larga influência no clima. E motiva preocupação porque persiste no ciclo atmosfera/superfície terrestre por muito tempo. 60% do CO2 que é produzido hoje permanecerá na atmosfera por mais 20 anos; 30% a 50% permanecerá por um século; e entre 15 a 30% manter-se-á na atmosfera mais de mil anos. Isto quer dizer que pequenas reduções na emissão de CO2 apenas abrandarão o aumento da concentração de CO2 na atmosfera, mas não o anulam. Para estabilizar essa concentração, e consequentemente a sua influência no aquecimento terrestre, teríamos de parar por completo as emissões.

O metano é o segundo gás com efeito de estufa mais importante, no que diz respeito à influência humana. Tem vindo a subir consistentemente desde o início dos anos 80 do século XX, embora um “planalto”, entre 1998 e 2008, intrigue os cientistas e constitua mais uma incerteza no seio da ciência climática. Mas a subida do metano vem de muito mais longe, pelo menos desde há 4 mil anos. As principais diferenças entre o metano e o CO2 são as seguintes.

- O metano tem uma concentração na atmosfera muito menor (2.000 partes por bilhão – mil milhões em português – enquanto o CO2 tem cerca de 400 partes por milhão).

- O metano dura apenas 12 anos na atmosfera, embora, depois disso, reações químicas o convertam em CO2.

- Devido às peculiaridades de como as moléculas interagem com as diferentes cores da radiação infravermelha, cada molécula adicional de metano na atmosfera é 30 vezes mais potente do que a molécula de CO2 no que diz respeito ao efeito de estufa.

As principais fontes de metano na atmosfera são os gases emitidos pelo gado, através da fermentação interna nos seus corpos (29%)12; petróleo e gás (20%); cultivo de arroz (10%); águas residuais (9%); estrume, mineração de carvão, decaimento de materiais em aterros, entre outros.

O futuro do clima terrestre será determinado pela resposta climática, quer à influência humana quer à influência natural, quer à sua variabilidade interna. Vulcões, o Sol e as correntes oceânicas profundas têm mentes próprias, tal como o clima em si mesmo. Quanto a isto, podemos fazer pouco, mas podemos ter uma noção sobre o que os humanos farão nos próximos anos, particularmente no que diz respeito às emissões de gases com efeito de estufa e aerossóis. Face às grandes incertezas sobre as décadas que aí vêm, em vez de fazer previsões credíveis, o IPPC cria cenários que têm o nome complicado de Representative Concentration Pathways ou, simplesmente, RCPs. Um ponto principal a retirar de qualquer cenário é que a influência humana continuará a crescer no curto prazo, mesmo que cessem na totalidade as emissões. Em suma, não é só difícil isolar a influência humana dentro do complexo sistema climático, mas também a relação entre emissões e concentrações na atmosfera torna extremamente difícil moderar as nossas influências.

Muitos modelos confusos

Para tentarem perceber como as coisas se vão desenrolar, os cientistas criam em computador os seus famosos modelos. Mas o que são exatamente os modelos climáticos? A resposta curta é que são programas de computador que correm sob simulações matemáticas do sistema climático. Tal como o estatístico George Box, da universidade de Wisconsin, disse em 1978: Todos os modelos estão errados, mas alguns são úteis. Um problema básico dos modelos climáticos é deduzível das dificuldades atuais das previsões meteorológicas, que não conseguem uma precisão superior a 15 dias, apesar de serem hoje muito mais precisas do que eram há 30 anos. Este problema fundamental foi descrito em 1961 por Ed Lorenz, do MIT. O tempo é caótico e pequenas alterações ao modo como iniciamos o nosso modelo podem conduzir a predições muito diferentes após poucas semanas. Então, não importa quão acuradamente podemos especificar as condições presentes, a incerteza das nossas predições cresce exponencialmente à medida que as projetamos no futuro. Computadores mais poderosos não podem ultrapassar esta incerteza básica.

Todos os modelos climáticos computorizados começam através da cobertura da atmosfera com uma rede tridimensional, tipicamente dez a vinte camadas de caixas empilhadas acima da rede de superfície, em quadrados de 100X100 quilómetros. A rede que cobre os oceanos é semelhante, mas menor, tipicamente 10X10 quilómetros, e mais camadas verticais (até 30 camadas). Com a totalidade da Terra coberta desta forma, há cerca de um milhão de caixas desta rede para a atmosfera e 100 milhões de caixas para o oceano. Uma vez estabelecida esta rede no terreno, os modelos de computador usam as leis da Física para calcular como o ar, água e energia em cada caixa, num dado momento, se movem para as caixas de rede vizinhas, um pouco mais tarde; este lapso de tempo pode ser tão curto quanto dez minutos. Repetindo este processo milhões de vezes, simula-se o clima para um século (pouco mais de 5 milhões de vezes se o lapso de tempo for de 10 minutos). Estes inúmeros lapsos de tempo numa simulação podem dar trabalho, mesmo ao mais poderoso computador do mundo, durante meses. Os investigadores podem alternar entre estes diferentes fatores, dependendo do propósito do modelo em questão. Um dos desafios maiores destes modelos é que apenas usam valores únicos para a temperatura, a humidade, etc., para descrever as condições no interior de uma caixa de rede.

No entanto, vários fenómenos importantes ocorrem numa escala menor do que os 100 kms (60 milhas) das caixas, tais como montanhas, nuvens e trovoadas, e por isso os investigadores têm de construir sub redes para construírem um modelo completo. Por exemplo, fluxos de luz solar e de calor através da atmosfera são influenciados pelas nuvens. Estas desempenham um papel crucial – dependendo do tipo e formação, as nuvens refletem a luz solar ou intercetam o calor, em quantidades variáveis.

Então, porque não construir caixas mais pequenas? Infelizmente, isso iria aumentar dramaticamente a dimensão da computação, desde logo porque teríamos muito mais caixas de rede com que lidar. Mas, além do número de caixas, uma rede mais fina introduz um outro problema: a computação só será acurada se as coisas não mudarem demasiado dentro de um lapso de tempo (ou seja, se não se moverem para lá de uma única caixa de rede). Assim, se a rede for mais fina, o lapso de tempo tem igualmente de ser menor, exigindo mais tempo de computação. Para ilustrarmos isto, uma simulação que dure dois meses para uma rede de 100 kms quadrados, levaria mais de um século se usássemos uma rede de 10 kms quadrados. Este tempo poderia ser reduzido para os mesmos dois meses se tivéssemos um supercomputador cem vezes mais rápido que os atuais – uma capacidade talvez disponível dentro de duas ou três décadas, mas não hoje.

Outro problema que se levanta prende-se com a forma como a nossa grelha divide a Terra em pedaços verticais versus horizontais. A atmosfera e os oceanos são ambos como finas conchas que cobrem a superfície terrestre – a profundidade média dos oceanos (4 kms) é muito pequena quando comparada com o raio da Terra (6.400 kms), bem como a altura da atmosfera (cerca de 100 kms). Para descrever com precisão as variações verticais, as várias dezenas de caixas empilhadas são mais parecidas com panquecas do que com cubos, centenas de vezes maiores em largura do que em altura13. Em geral, as simulações são mais acuradas nas partes superiores da pilha de “panquecas”, mas estas caixas achatadas tornam-se um problema nas partes da atmosfera abaixo dos 10 kms, onde o tempo turbulento ocorre. As trovoadas têm lugar em áreas muito menores do que os 100 kms da nossa rede. Isto é particularmente importante nos trópicos, onde há um significativo fluxo de energia e vapor de água, transportados para a atmosfera pela evaporação da água dos oceanos. Deste modo, são necessárias sub redes que assumam esta “convecção húmida” – a forma como o ar e o vapor de água se movem verticalmente através das caixas achatadas – para se construírem modelos fiáveis. De facto, a maior incerteza da modelagem climática decorre do tratamento das nuvens.14

Qualquer simulação precisa também de ser “iniciada”, ou seja, precisamos de alguma forma especificar as condições do oceano e da atmosfera no início do primeiro lapso de tempo: temperatura, humidade, ventos, etc., em cada caixa da atmosfera, bem como temperatura, salinidade, correntes, etc., em cada caixa de rede do oceano. Infelizmente, mesmo com os meios sofisticados de observação existentes, esse tipo de detalhe não está ao nosso alcance, muito menos estaria nas décadas passadas. Além disso, o nível caótico da simulação tornaria a maioria dos detalhes irrelevantes passadas duas ou três semanas. Assim, a etapa inicial (1º lapso de tempo) capta apenas de forma grosseira as condições de partida. Em cada evento, por razões práticas e fundamentais, é impossível ajustar dezenas de parâmetros para que o modelo corresponda às muito mais numerosas propriedades observadas do sistema climático. As nossas limitações não nos permitem entender as características do clima, nem sequer perto dos níveis de especificidade exigidos.

Entre as coisas mais importantes que um modelo tem de considerar estão os chamados feedbacks. O crescimento da concentração de gases com efeito de estufa que provocam o aquecimento global pode também causar outras mudanças no sistema climático, as quais podem ampliar ou diminuir a sua própria influência nesse aquecimento. Por exemplo, à medida que o globo aquece, há menos neve e gelo na superfície terrestre, o que provoca a diminuição do albedo terrestre. A Terra menos reflexiva irá então absorver mais luz solar, causando ainda mais calor. Um outro exemplo de um feedback é que, à medida que a atmosfera aquece, vai carregar mais vapor de água, o que vai aumentar bastante a sua capacidade de intercetar o calor libertado. Mas mais vapor de água vai também transformar a cobertura de nuvens, aumentando quer a interceção de calor (nuvens altas) quer a reflexividade (nuvens baixas). Neste balanço ganha a reflexividade, e o feedback da rede de nuvens, de alguma forma, diminui o aquecimento direto.

É por tudo isto que os ajustamentos (tuning) são necessários mas perigosos, quer nos modelos climáticos, quer em qualquer sistema complexo. Um artigo de 15 proeminentes cientistas do clima põe as coisas nestes termos:

As escolhas e os compromissos feitos durante os ajustamentos podem significativamente afetar os resultados do modelo… Em teoria o tuning deveria ser levado em conta em qualquer avaliação, comparação ou interpretação dos resultados do modelo… Porquê uma tal falta de transparência? Isto pode acontecer porque a “sintonização” é frequentemente vista como uma parte suja, embora inevitável, da modelação climática, mais engenharia que ciência, um ato de desafinação que não merece ser registado na literatura científica. Também pode haver alguma preocupação em explicar que os modelos são ajustados, pois isto pode fortalecer os argumentos daqueles que questionam a validade das projeções sobre mudanças climáticas. Os ajustamentos podem ser vistos, sem dúvida, como uma inconfessável forma de compensar os erros dos modelos.15

Acresce a tudo isto que os resultados dos diferentes modelos divergem entre si, sendo que, quanto à temperatura média da superfície terrestre, chegam a divergir em 3ºC. Isto é particularmente chocante se tivermos em consideração que 3ºC são três vezes maiores que o valor de aquecimento observado durante o século XXI, valor esse que os próprios modelos buscam explicar e descrever. Dois modelos cuja temperatura de superfície média varie deste modo vai igualmente variar bastante nos seus detalhes. Por exemplo, uma vez que não é possível ajustar a temperatura de congelamento da água (determinada pela natureza), a quantidade de neve e gelo que cobrem a Terra, e consequentemente os albedos, podem ser muito diferentes.

Dado que nenhum modelo bate certo, o resultado médio dos relatórios de avaliação é deduzido de um “conjunto” de algumas dezenas de modelos de diversos grupos de pesquisa espalhados pelo mundo. O CMIP (Coupled Model Intercomparison Project) compila estes conjuntos. O conjunto CMIP3 está na base do relatório de avaliação AR4 do IPCC; por sua vez o CMIP5 sustenta o relatório AR5, de 2013, enquanto o CMIP6 fundamentará o relatório de avaliação conhecido por AR616. Surpreendentemente, alguns dos atuais modelos são menos precisos que modelos antigos, apesar de mais sofisticados. O próprio IPCC, embora numa linguagem asséptica, reconhece não ter ideia do que causa as falhas nos modelos, nomeadamente quando previram metade do aquecimento realmente observado entre 1910 e 1940. Isto é altamente problemático porque o aquecimento observado no início do século XX é comparável ao observado no final do século, o qual, de acordo com os relatórios de avaliação, é atribuído com “elevada confiança” à influência humana. O IPCC reconhece que é difícil quantificar as contribuições da variabilidade interna, das forças naturais ou antropogénicas para este aquecimento.17

A variabilidade interna que o IPCC refere como difícil de quantificar, embora considerado um assunto menor, é de facto um grande problema. Observações climáticas mostram claramente comportamentos repetidos ao longo de décadas e mesmo séculos. Pelo menos alguns deles devem-se a lentas mudanças nas correntes oceânicas e à interação entre o oceano e a atmosfera. O exemplo mais conhecido é o dos fenómenos associados ao El Niño (tecnicamente, El Niño -Southern Oscilation), uma alteração no calor ao longo da região equatorial do Oceano Pacífico, que ocorre irregularmente entre 2 a 7 anos e influencia a meteorologia mundial. Um comportamento lento menos conhecido é a “Oscilação Multidecadal do Atlântico” (Atlantic Multidecadal Oscilation – AMO), que envolve mudanças cíclicas de temperatura (entre 60 a 80 anos) no Atlântico Norte. O Oceano Pacífico mostra um similar, embora não relacionado, comportamento cíclico de cerca de 60 anos. Dado que temos apenas 150 anos de boas observações e registos, comportamentos sistemáticos que ocorrem em escalas de tempo maiores são menos conhecidos – mas podem existir (e quase de certeza que existem) outras variações cíclicas naturais, que ocorrem ao longo de períodos ainda maiores.

Estes ciclos influenciam o clima aos níveis regional e global e sobrepõem-se a qualquer tendência, humana ou natural, como a emissão de gases com efeito de estufa ou os aerossóis de origem vulcânica, e tornam difícil determinar que mudanças observadas se devem à influência humana ou à influência natural. O falhanço, mesmo dos modelos mais recentes, para justificar o rápido aquecimento ocorrido nos anos iniciais do século XX sugere, torna mesmo provável, que a variabilidade interna – os fluxos e refluxos naturais dos sistemas climáticos – tenha contribuído significativamente para o aquecimento que vem ocorrendo nas últimas décadas. O facto de os modelos não conseguirem reproduzir o passado constitui um grande cartão vermelho e degrada a confiança em projeções futuras. Isto reflete-se no ECS – Equilibrium Climate Sensitivity, ou seja, no valor em que subirá a temperatura média da superfície terrestre se a concentração de CO2 hipoteticamente duplicar os 280 ppm da época pré-industrial. Se as emissões se mantivessem ao ritmo atual, essa duplicação aconteceria até ao final deste século. O que acontece é que esse valor não tem agora um grau de certeza maior do que tinha em 1979 (o valor estimado nessa altura era de 3ºC.)

Os modelos dão-nos valores diferentes, que vão dos 2ºC até aos 5,5ºC. Estes altos ECS parecem resultar da sub-rede que inclui a interação das nuvens com os aerossóis nos modelos, algo que não é bem compreendido, mas que inibe o aquecimento, ao aumentar o albedo da Terra. Por outras palavras, os investigadores ajustam os seus modelos ao que eles pensam corresponder ao aumento dos gases com efeito de estufa, ou seja, cozinham os resultados. Num artigo publicado em julho de 2020, vinte cientistas combinaram as abordagens verticais e em grade (juntamente com algumas informações observacionais e de períodos antigos) na tentativa de definir a sensibilidade do clima. Os autores encontraram um intervalo provável para o ECS de 2,6 a 4,1º C, metade do estimado pelo AR5 (1,5-4,5ºC), o que significa que valores extremamente baixos ou extremamente altos são considerados pouco prováveis.18 Não surpreende que tenhamos uma pobre compreensão sobre como o clima vai responder ao aumento das concentrações de gases com efeito de estufa. Quanto mais aprendemos sobre o sistema climático, mais temos noção do quão complicado ele é.

Exagerando no calor

O que vemos quase diariamente na comunicação social são notícias sobre secas, incêndios, cheias, tempestades, etc., “sem precedentes”. Dado que a memória humana é relativamente curta, a maioria das pessoas acredita. Mas a ciência conta-nos uma história diferente. Observações desde há um século indicam que a maioria dos fenómenos meteorológicos extremos não mostram qualquer tendência significativa, e alguns destes eventos tornaram-se, na realidade, menos comuns e severos, mesmo com o aumento da influência humana sobre o clima.

Por outro lado, é difícil detetar mudanças em eventos extremos, bem como atribuí-los à influência humana, devido à baixa qualidade dos registos históricos, à elevada variabilidade natural, a influências naturais difíceis de determinar, e ao desacordo sobre os inúmeros modelos usados. Sobre a dificuldade em determinar a influência humana, a Organização Meteorológica Mundial coloca de forma clara a questão: cada evento, por exemplo um ciclone tropical, furacão ou tufão, não pode ser atribuído a mudanças climáticas provocadas pelo homem, tendo em conta o conhecimento científico atual.19

Nos Estados Unidos, país que tem os registos mais extensos e de maior qualidade sobre a temperatura, os recordes de baixas temperaturas são agora menos comuns, e os recordes diários de temperaturas mais altas não são mais frequentes hoje do que eram há um século. Porque temos então a sensação de que as temperaturas extremas estão a aumentar? Uma das razões é que os relatórios são objeto de múltiplas revisões. Por questões ideológicas, muitas vezes, os dados são deturpados. Por exemplo, um quadro apresentado pelo CSSR – Climate Science Special Report (Relatório Especial sobre Ciência Climática), que mostra o racio do registo diário de recordes de altas temperaturas versus o registo diário de recorde de baixas temperaturas, é enganador, pois leva a concluir que o número de recordes da altas temperaturas está a ocorrer com mais frequência, o que não corresponde à verdade, o que acontece é que o número de recordes de temperaturas mínimas está a baixar mais do que o de temperaturas máximas. Chama-se a isto persuadir em vez de informar. Assim, não surpreende que os media desinformem e não digam a verdade, que é a de que, afinal, os recordes de mínimas estão a diminuir e os recordes de máximas temperaturas quase não se alterou nas últimas décadas.

Terrores de tempestades

De acordo com os media, as tempestades estão a tornar-se mais comuns e mais intensas, e o aumento dos gases com efeito de estufa estão a tornar tudo isto ainda pior. No entanto, os dados e a literatura de pesquisa estão totalmente em desacordo com esta mensagem. No centro desta confusão estão os relatórios de avaliação, que apresentam sumários inconsistentes em relação às suas próprias conclusões. Mas a verdade é que furacões e tornados não mostram mudanças atribuíveis à influência humana. Tecnicamente, “furacão” é o termo usado para um ciclone tropical no Atlântico ou no leste do Pacífico; estas tempestades são chamadas “tufões” no Pacífico Oeste e apenas “ciclones” na Baía de Bengala e no norte do Oceano Índico. Para evitar confusões, Koonin não se faz essa distinção, considera no livro que todos essas tempestades são furacões. Com uma extensão de até algumas centenas de milhas, estes sistemas de tempestade apresentam um centro (“olho”) de baixas pressões, rodeado por uma espiral (contrária ao sentido dos ponteiros do relógio no hemisfério norte e no sentido dos ponteiros do relógio no hemisfério sul) de trovoadas e tornados, produzindo chuva pesada. Quanto mais baixa for a pressão do olho, mais fortes serão os ventos em seu torno. Um furacão apresenta ventos superiores a 119 km/h; se for mais fraco, é chamado “tempestade tropical”, e se for ainda mais fraco é conhecido por “depressão tropical”. Os furacões são categorizados pela sua intensidade através da escala Saffir-Simpson, que vai de 1 a 5. As maiores tempestades (as de categorias 3 a 5) têm ventos superiores a 179 km/h.20

Os furacões crescem de depressões tropicais (áreas de baixa pressão) nascidas sobre os oceanos ao longo do equador. De seguida movem-se no sentido dos polos, dependendo o seu caminho preciso dos ventos regionais; a maioria nunca chega ao solo. Há cerca de 48 furacões por ano em todo o globo. Dois terços ocorrem no hemisfério norte (onde a temporada de furacões vai de junho a novembro) e um terço no sul (de novembro a maio). Em números redondos, cerca de 60% ocorrem no Pacífico, 30% no Índico, e 10% no Atlântico Norte. São muito raros no Atlântico Sul. Os cientistas desenvolveram outras formas de medir as tempestades. Uma delas é a Energia Acumulada do Ciclone (ACE – Accumulated Cyclone Energy), que combina o número de tempestades com a sua intensidade, e outra é o Índice de Energia de Dissipação (PDI- Power Dissipation Index), semelhante à ACE, mas que confere um peso ainda maior às tempestades mais intensas (cada tempestade é medida pelo cubo, ou 3ª potência, da sua velocidade de vento).

As áreas de baixas pressões que se transformam em furacões formam-se a partir da evaporação da água do mar numa zona quente; essa água liberta calor à medida que sobe e se condensa na atmosfera. Assim, podemos esperar um incremento na atividade dos furacões à medida que a superfície do mar aquece. Infelizmente, não é assim tão simples, como se pode comprovar pelos registos de longo prazo dos números anuais e da ACE de furacões no Atlântico Norte. As flutuações de longo prazo da Oscilação Multidecadal do Atlântico (AMO – Atlantic Multidecadal Oscillation), atrás referida, afeta a temperatura da superfície do mar onde se formam os furacões e pode, por isso, aumentar ou suprimir a sua atividade. As condições atmosféricas têm que ser precisas para que um furacão se forme, não apenas a temperatura. Há uma série de outros fatores a ter em conta, como a variação da velocidade do vento e a sua direção com a altitude, ou a presença de poeira do Sahara, nenhum dos quais descritos pelos modelos climáticos.

Como é evidente, o facto de a temperatura não ser o único fator a ter em conta na formação de furacões não quer dizer que o aquecimento, natural ou causado pelo homem, não tenha influência. Tem havido, como sempre há em tudo que tem a ver com o clima, oscilações no número e intensidade dos furacões nos últimos anos, talvez porque o ciclo AMO esteja numa fase alta, mas tal já ocorreu no passado e, se alongarmos o período de registos, verificaremos que houve tempos em que a atividade era pelo menos tão grande como a que temos hoje, mesmo antes da influência humana se tornar significativa. Assim, a maioria dos autores tem “baixa confiança” (low confidence) em que alterações na frequência e intensidade dos ciclones tropicais estejam além do que possa ser atribuído à variabilidade natural. No entanto, os media não dão conta desta realidade, preferindo propagar o alarme não fundamentado. É verdade que os danos económicos provocados pelos furacões estão a aumentar, mas isto acontece porque hoje há mais pessoas e mais infraestruturas valiosas nas zonas costeiras, não porque as características das tempestades tenham mudado no longo prazo.

Seja o que for que o futuro nos reserve, as descrições dos dados sobre furacões, presentes nos relatórios de avaliação, pecam por omissão; violam o que Einstein uma vez disse no edifício da Academia Nacional, em Washington: “O direito da busca pela verdade implica também um dever; não devemos esconder nenhuma parte do que reconhecemos ser verdadeiro”. É claro que os furacões não são as únicas tempestades que causam estragos e ganham manchetes. Vejamos os tornados. O seu número tem aumentado significativamente. Mas isto ilustra perfeitamente os perigos da correlação. Uma simples pesquisa no Google revela-nos que também o números de barcos de pesca ou de filmes violentos duplicou desde 1950 e, com certeza, nenhuma destas tendências se deve a alterações climáticas. No caso dos tornados, a chave para esta “tendência” reside na compreensão de como os dados são compilados – o que é frequentemente tão importante quanto os dados em si. Como são, afinal, os tornados contabilizados?

Hoje em dia os radares detetam tornados muito fracos, distantes mais de 160 kms, mas antes dos radares estarem largamente disponibilizados os tornados fracos nem sempre eram registados. Estes tornados mais fracos nem sempre deixam um rastro de destruição, sobretudo nas áreas escassamente povoadas. A força dos tornados é medida na escala Fujita (Enhanced Fujita Scale), originalmente desenvolvida em 1971, com uma versão aumentada em 2007. A categorização dos tornados vai de EF0 para as tempestades mais fracas até ao EF5, para as que têm ventos acima das 260 mph (milhas/hora). Sessenta por cento dos tornados nos Estados Unidos são hoje da categoria EF0, enquanto em 1950 essa categoria representava apenas 20%. Isto sugere que o aumento do número de tornados se deve à maior contagem de fracas tempestades nas décadas recentes, o que, de acordo com a NOAA (National Oceanic and Atmospheric Administration), é, de facto, o caso.21 De acordo com os registos no terreno, se tivermos em conta apenas os tornados de força EF1 ou superiores, verifica-se que o seu número não varia muito desde 1974. Mas se tivermos em consideração o número de tornados da categoria EF3 ou de força superior, o que se verifica é que o seu número decresceu em cerca de 40% nos 60 anos que se seguiram a 1954.

Os dados também nos dizem que há menos dias/ano com tornados, mas maior número de tempestades nos dias em que estas ocorrem. As causas, naturais ou humanas, que provocaram estas mudanças ao longo das últimas décadas mantém-se um mistério. No entanto, podemos com confiança atribuir à influência humana uma grande mudança relacionada com os tornados: as mortes provocadas pelos tornados caíram mais de dez vezes desde 1987 nos Estados Unidos, o que se deve, em larga medida, aos avisos dos radares.22

Perigos de Precipitação – das Inundações aos Incêndios

As relações entre tempo e clima são complicadas, especialmente para a precipitação, sob a forma de chuva ou de neve. Por exemplo, embora possa parecer contraintuitivo, a subida da temperatura pode afinal contribuir para que neve mais – se um aumento das temperaturas mínimas impedir o congelamento do Oceano Ártico no inverno, mais água será evaporada para a atmosfera. De acordo com os registos, os grandes nevões no mundo desenvolvido têm vindo a decrescer, embora de forma muito lenta e pouco acentuada. Desconhece-se qual a influência humana nesta tendência, se é que existe de todo.

Quanto à precipitação, temos de considerar o seguinte. O volume de água existente na Terra é, essencialmente fixo. Quase todo (cerca de 97%) está nos oceanos, e quase todo o resto encontra-se em Terra – no gelo e na neve (especialmente na Gronelândia e nos lençóis de gelo do Ártico, em lagos e rios, e no subsolo. No entanto, a água terrestre que se encontra na atmosfera tem um papel central no clima, visto que o vapor de água é o mais importante gás com efeito de estufa, e as nuvens contribuem para a maior parte do albedo terrestre. A energia solar movimenta a água entre estes diversos reservatórios e forma o chamado ciclo hidrológico. A maior e mais dinâmica parte deste ciclo é o fluxo de água que sobe da superfície terrestre para a atmosfera (85% deste fluxo advém da evaporação dos oceanos, os outros 15% da superfície terrestre, a maior parte da transpiração das plantas). Essa água mantém-se nas alturas por uma média de 10 dias, antes de condensar e cair de novo, na forma de chuva ou neve (77% cai nos oceanos e 23% no solo terrestre). Globalmente, a chuva é mais intensa perto do equador (onde muita da água evaporada volta à superfície à medida que o ar quente e húmido sobe e arrefece) mas baixa onde o ar seco desce, criando os desertos que flanqueiam o equador.

O lugar mais seco da Terra fica na América do Sul, no extremo norte do deserto de Atacama, no Chile: Arica, onde chove apenas 0,6 mm por ano. O mais húmido é Mawsynram, na Índia, com a média de 11,871 mm/ano. Se todo o resto se mantiver igual, é expectável que o ciclo hidrológico se intensifique à medida que o globo aquece: haverá mais evaporação e o ar quente transportará mais água, conduzindo a mais precipitação. É igualmente expectável que esta precipitação seja mais pesada, com áreas secas a ficarem ainda mais secas e as áreas húmidas ainda mais húmidas, com mais períodos de intensa precipitação. Isto pode levar a inundações em algumas áreas, mas uma vez que as temperaturas mais elevadas devem também aumentar a evaporação, as secas podem também aumentar. Há escasso consenso entre os modelos acerca de como, onde e quando estas alterações têm lugar.

Além disso, é bastante difícil escolher e analisar dados que sejam úteis para testar as expectativas sobre o que pode acontecer, e mesmo até responder a uma questão básica como: “como tem mudado a média de precipitação?” Ao contrário das alterações na temperatura, a precipitação pode variar enormemente em curtas distâncias e em poucos minutos – pode chover em determinado local, embora o tempo esteja perfeitamente seco a 30 kms (ou mesmo 3 kms) de distância. Isto acontece porque, como mencionado atrás, acontecem alterações súbitas nas propriedades da água: em função da temperatura e da quantidade de vapor de água, a água pode condensar e criar precipitação ou não. Assim, ao contrário do que acontece com a temperatura, não há nenhuma forma fácil de combinar os dados sobre precipitação recolhidos pelas estações meteorológicas espalhadas pelo mundo e obter um quadro geral da situação. No entanto, a combinação de dados registados por observações no solo e por satélite permite-nos projetar um quadro global de longo prazo, mais apurado sobre as zonas onde as estações meteorológicas são mais numerosas. Apesar disso, como se mostra num artigo publicado por um grupo de cientistas no Bulletin of the American Meteorological Society, em 2018: … Não parece haver qualquer tendência positiva no volume global de precipitação, devido ao aumento global de temperatura. Porquanto haja tendências regionais, não há evidência de aumento de precipitação à escala global em consequência do aquecimento global observado.23

Outro aspeto de particular importância para o sistema climático, no que diz respeito à precipitação, é a cobertura de neve que aumenta o albedo terrestre. Observações por satélite no hemisfério Norte mostram que há um declínio na cobertura de neve durante a Primavera (e também com algum significado no Verão), como seria expectável num globo a aquecer – especialmente num em que as baixas temperaturas estão a aumentar, enquanto a neve durante o Outono e o Inverno aumentou modestamente. As pequenas alterações no volume de precipitação nos Estados Unidos ao longo dos anos, não alteram a média de incidência de inundações.

As secas são ainda mais difíceis de determinar do que as inundações, uma vez que não resultam apenas da precipitação (ou, antes, da falta dela). Ao contrário, as secas envolvem combinações de temperatura, precipitação, composição e capacidade de escoamento do solo. Atividades humanas, como a irrigação, que esgota a água no solo, ou o esgotamento das terras por excesso de aragem (de “arar” a terra), como aconteceu durante os Grandes Planos americanos nos anos 1930, também jogam um papel. As secas medem-se através do Índice de Gravidade da Seca de Palmer (PDSI – Palmer Drought Severity Index). Secas severas têm acontecido ao longo dos milénios, e os dados, sobretudo através dos registos nos anéis, mostra-nos muitas secas que perduraram por décadas, muitas antes de 1900, incluindo as mega secas de 900 a 1300 AD, e que, portanto, não podem ser atribuídas a influências humanas, mas antes ao aquecimento natural do globo naquela época. O AR5 de 2014 reconhece que “pode dizer-se com elevada confiança que houve secas de maior magnitude e mais longa duração no último milénio, do que aquelas observadas em muitas regiões nos últimos cem anos.

As secas tornam os incêndios mais severos e os grandes incêndios dominam as parangonas dos jornais, que atribuem as causas dos mesmos às alterações climáticas. Apesar disso, os dados mostram-nos que a área ardida, a nível global, diminuiu 25% de 1998 até 2015. Uma das razões para este declínio é atribuída pelos cientistas à atividade humana, nomeadamente à expansão e intensificação da agricultura. Mais uma vez, os modelos são imperfeitos e as previsões incertas. Não se conhece exatamente que papel desempenha a humanidade relativamente a estes aspetos do clima no futuro.

O Nível do Mar Assusta

Depois dos oceanos, a maior reserva de água da Terra está nos lençóis de gelo da Gronelândia e do Ártico. Enquanto numerosos fatores contribuem para pequenas alterações do nível do mar, o que conta mais, o que é mesmo mais importante ao longo do tempo geológico, depende do gelo que se encontra nos solos. Ciclos lentos – variações na órbita da Terra e na inclinação do seu eixo ao longo de dezenas de milhares de anos – alteram a quantidade de luz solar absorvida pelos hemisférios Norte e Sul. Essas alterações causaram grandes oscilações na temperatura global durante milhões de anos. E também provocam o crescimento ou a diminuição dos lençóis de gelo que cobrem os continentes (os intervalos são tecnicamente chamados “glaciações” e “interglaciações”, respetivamente), despejando menos ou mais água nos oceanos, e assim causando a descida ou subida dos níveis do mar. Por exemplo, durante o último período interglacial (pouco gelo), há 125 mil anos, conhecido por Eemian (Eemiano), o nível dos mares era cerca de 6 metros mais alto do que é hoje.

O último Glaciar Máximo ocorreu há cerca de 22 mil anos, altura em que os glaciares continentais começaram a derreter de novo. A Terra encontra-se hoje no interglacial Holoceno, que os geólogos acreditam ter começado há 12 mil anos. De acordo com os dados geológicos, o nível do mar subiu cerca de 120 metros desde o Último Glaciar Máximo, muito rapidamente (120mm por década) até cerca de 7 mil anos atrás, tendo depois essa subida abrandado drasticamente. A questão, portanto, não é a de saber se o nível dos mares está subindo, mas de que forma os seres humanos contribuem (ou não) para isso. Nas últimas três décadas o nível do mar subiu cerca de 3mm por ano, mais do que a média de 1,8 mm desde 1880. No entanto, a média não nos diz nada sobre se ocorreram ou não períodos de maiores subidas, como este dos últimos 30 anos.

Para sermos claros, o nível dos mares sobe à medida que a temperatura do globo sobe. Quando a temperatura de superfície terrestre aumenta, o gelo derrete – e à medida que os oceanos aquecem, a água que contêm expande-se. Os níveis sobem e descem sazonalmente no longo prazo, em resposta aos ciclos orbitais discutidos anteriormente, e em resposta às influências naturais ou humanas. Enquanto as taxas de subida ao longo do século passado tiveram significativos altos e baixos, um globo em aquecimento provoca, indubitavelmente, mais água nos oceanos. O que acontecerá, então, ao nível dos mares, no futuro? A resposta depende sobretudo da quantidade de gelo que derrete na superfície terrestre, à medida que as temperaturas sobem, e também do aumento da temperatura dos oceanos.

No entanto, sabe-se que o derretimento do gelo ao nível global diminuiu desde 1900 e é hoje o mesmo que há 50 anos; a contribuição da Gronelândia para este derretimento atingiu um nível mínimo em 1985 e não é agora mais elevado do que era em 1935. Os cientistas que constroem os modelos deparam-se com um problema fundamental: não compreenderam as alterações que ocorrem na Antártida e na Gronelândia que determinaram o volume dos oceanos e, consequentemente, a subida ou descida do nível dos mares. Os dados sugerem que há ciclos que condicionam o nível das águas, nomeadamente o AMO (Oscilação Multidecadal do Atlântico)24, já referido, sendo expectável que esse nível desça durante as próximas décadas, ao contrário do que é divulgado pela comunicação social.

Em suma, não sabemos o quanto da subida do nível global do mar é devida ao aquecimento provocado pelo homem, e quanto é devido aos ciclos naturais de longo prazo. Há poucas dúvidas de que, ao contribuirmos para o aquecimento do planeta, também contribuímos para a subida do nível dos mares. Mas há pouca evidência de que essa contribuição seja significativa, muito menos catastrófica. A tendência dos humanos construírem cidades nas zonas costeiras também tem contribuído para o aumento do nível dos mares.25

Apocalipses que não são

Os supostos apocalipses, que afinal, não o são, são três:

- Mortes causadas pelas alterações climáticas.

- Desastre na agricultura.

- Desastre na economia

Quanto ao primeiro, é preciso reconhecer que as pessoas não morrem por causa do clima. O clima muda devagar e as sociedades adaptam-se ou migram. Mas as pessoas morrem devido a eventos meteorológicos relacionados com o clima – secas e inundações, tempestades, temperaturas extremas e grandes incêndios, embora tenhamos já visto que estamos longe de ter alguma certeza de que alterações no clima provoquem estes fenómenos. Desde 1930, as mortes provocadas por fenómenos meteorológicos decaíram consecutivamente, sendo hoje menos de metade do que as que ocorriam naquela década. Por outro lado, muitas mortes atribuídas ao clima – como aquelas provocadas pelo cozinhar com madeira e restos de animais e plantas – são na realidade causadas pela pobreza. Não há dúvida de que a poluição afeta o clima (como vimos, os aerossóis provocam o arrefecimento do planeta), mas as mortes devidas à poluição não são causadas pelas alterações climáticas, antes pela própria poluição.

Quanto ao suposto desastre na agricultura, é importante começar por referir que o aumento da concentração de dióxido de carbono tem sido um fator muito relevante para o aumento da produção agrícola, uma vez que impulsiona a taxa de fotossíntese e altera a fisiologia das plantas, fazendo com que usem a água de forma mais eficiente.26, 27 2020 foi o ano-recorde da produção de grãos. Em suma, o que a ciência realmente nos diz é que o colapso nas colheitas derivado do clima é outro apocalipse que, simplesmente, não o é. E, consequentemente, nada indica que possa ocorrer, devido às “alterações climáticas”, um desastre económico.

Fica claro que os media, os políticos e frequentemente os próprios relatórios de avaliação desvirtuam descaradamente o que a ciência diz sobre clima e catástrofes. Essas falhas devem ser atribuídas aos cientistas que escrevem ou reveem os relatórios, os repórteres que acriticamente os refletem, os editores que permitem que tal aconteça, os ativistas e as suas organizações que primem os botões de alarme, e os especialistas cujo silêncio público engrossa o engano.

Quem degradou a ciência e porquê

Há vários responsáveis pela desinformação que passa para o público sobre as alterações climáticas. Eis os principais: os media; os políticos; as instituições científicas; os cientistas; os ativistas e as ONGs; o próprio público. Claro que nem todos os membros destes grupos alinham no alarme geral, mas os que o fazem são suficientes para sustentar essa tendência, que se tornou maioritária e, mais do que isso, uma verdade incontestável na maior parte da opinião pública mundial. Os media são responsáveis porque destacam, na abertura de telejornais ou em parangonas na imprensa, aquilo que vende mais: o alarmismo. Isto é particularmente verdade no que toca às matérias sobre clima e energia. Informar em profundidade não vende, é muito mais rentável a manchete sensacionalista – sobretudo num mundo onde a partilha de notícias nas redes sociais é a parte mais importante do negócio – até porque há sempre, algures no mundo, uma história sobre um qualquer evento meteorológico extremo para contar.

Por outro lado, a maioria dos jornalistas não tem formação científica. E isto é muito importante porque, como vimos, os próprios relatórios de avaliação podem ser mal interpretados, sobretudo por quem não é especialista. Assim, os jornalistas embarcam facilmente na missão de salvar o mundo da destruição humana, considerando o alarmismo correto, mesmo um dever, o qual se deve, em larga medida, ao desconhecimento que têm do desenvolvimento atual da ciência climática. Quanto aos políticos, é preciso notar que ganham eleições agradando ao público, de alguma forma, dizendo o que este quer ouvir. Isto não é novo. Como notou H. L. Mencken’s no seu livro Em Defesa das Mulheres, de 1918:

Todo o propósito da prática política é manter a populaça alarmada (e, consequentemente, ansiosa por segurança), assustando-a com uma série infindável de duendes, a maioria imaginários.28

As ameaças de catástrofe climática – tempestades, secas, subida dos mares, destruição de colheitas, colapso económico – impacta em toda a gente. E essas ameaças podem ser consideradas urgentes (envolvendo um recente evento climático mortífero, por exemplo), mas também suficientemente distantes para que as terríveis previsões de um político sejam postas à prova apenas décadas depois de ele deixar o cargo. Por outro lado, e embora a ciência climática e as questões energéticas associadas sejam complicadas, a complexidade e as suas nuances não se adequam a mensagens políticas eficazes. Assim, a ciência é descartada em favor da Ciência e “simplificada” para uso na arena política, o que permite que as ações necessárias sejam resumidas de forma simples – basta eliminar os combustíveis fósseis para salvar o planeta. É claro que este não é um problema específico do clima, e o eleitorado – que odeia zonas cinzentas – tem a sua quota-parte de culpa.

Alguns políticos tentaram descaradamente minar o processo científico. Michael Bloomberg e Tom Steyer, dois políticos bilionários, tinham o objetivo de “fazer a ameaça climática parecer real, imediata e potencialmente devastadora para o mundo dos negócios.” Conspiraram com alguns cientistas, entre outros, para produzir uma série de relatórios descaracterizando o cenário de emissões extremas RCP 8.5 como “negócio de sempre” (ou seja, um mundo que não se esforça para conter as emissões). Os relatórios foram acompanhados por uma campanha sofisticada para infundir essa noção em conferências e revistas científicas.29 Aqueles que procuram corromper dessa forma o processo científico jogam o mesmo jogo que a multidão anticientífica que eles condenam em voz alta. Felizmente, a fraude está sendo denunciada agora nas principais revistas científicas.30

Finalmente, é prática comum sugerir que muitos dos políticos de direita, que defendem a ideia de “uma farsa da mudança climática”, são influenciados por vínculos a industriais afetados negativamente pela regulamentação ambiental restritiva. Infelizmente, à medida que a indústria das energias alternativas cresce, há incentivos financeiros para que os políticos também exagerem na tónica da catástrofe climática. A ciência não deve ser partidária, mas a interligação da ciência climática com a política, em geral, e com a política energética, em particular, praticamente garantiu que isso iria acontecer.

Quanto às instituições científicas, deveriam merecer o nosso apoio, pois é nelas que se baseia a nossa confiança – e a dos media e dos políticos – no que nos é apresentado como A Ciência. No entanto, quando se trata de clima, essas instituições parecem, frequentemente, mais preocupadas em fazer a ciência encaixar-se numa narrativa, do que em garantir que a narrativa se encaixe na ciência. Já vimos que as instituições que preparam as avaliações oficiais têm um problema de comunicação, sumariando ou interpretando os dados de formas ativamente enganadoras. Outras instituições, ou os seus líderes, exageram também na sua intenção de persuadir em vez de informar. Vejamos, por exemplo, o que disseram os presidentes das Academias Nacionais de Ciência, Engenharia e Medicina, nos Estados Unidos, em 28 de junho de 2019:

Os cientistas sabem, desde há algum tempo, por múltiplas linhas de evidência, que os humanos estão a alterar o clima da Terra, sobretudo através da emissão de gases com efeito de estufa. A evidência dos impactos das alterações climáticas são igualmente claros bem como o seu crescimento. A atmosfera e os oceanos estão a aquecer, a magnitude e frequência de certos eventos extremos estão a aumentar, e o nível do mar está a subir ao longo das nossas costas.31

Mesmo considerando a necessidade de concisão, esta é uma forma enganadora, incompleta e imprecisa de mostrar o que nos diz a ciência climática. Confunde o aquecimento causado pelo homem com mudanças climáticas em geral, sugerindo, erradamente, que as influências humanas são as únicas responsáveis por essas mudanças. Invoca “certos eventos extremos”, enquanto omite o facto de que a maioria deles (incluindo aqueles que afloram mais rapidamente à mente quando se lê a frase “eventos extremos”, como os furacões) não mostram nenhuma tendência significativa. E afirma que “o nível do mar está a subir” de uma forma que não só sugere que isso também é apenas atribuível ao aquecimento causado pelo homem, mas que também omite o facto de que essa subida não é novidade.

Quando a comunicação da ciência climática é corrompida desta forma, isso mina a confiança que as pessoas têm no que o establishment científico diz sobre outras questões sociais cruciais (o COVID-19 é o notável exemplo recente). Tal como Philip Handler, um ex-presidente da Academia Nacional de Ciências, escreveu num editorial de 1980:

É tempo de regressar à ética e às normas da ciência para que o processo político possa decorrer com maior confiança. O público pode perguntar porque ainda não sabemos o que parece vital para a tomada de decisão – mas a ciência manterá o seu lugar na estima do público apenas se admitirmos firmemente a magnitude das nossas incertezas e, consequentemente, afirmarmos a necessidade de mais pesquisas. E perderemos esse lugar se dissimularmos ou se argumentarmos como se todas as informações e entendimento necessários estivessem disponíveis. Os cientistas servem melhor as políticas públicas cingindo-se à ética da ciência, e não à ética da política.32

A verdade é que os cientistas não deveriam ceder à pressão institucional, seja do governo, de uma empresa ou de uma organização não governamental, e nem sequer deveriam recear a pressão dos seus pares. Tal como Richard Feynman afirmou, a integridade científica tem de ser mantida e isso só pode ocorrer se o cientista for imune a pressões: se tiver a sorte de estar em algum lugar onde seja livre para manter o tipo de integridade que descrevi e onde não se sinta forçado, pela necessidade de manter uma posição, ou de apoio financeiro, ou outra qualquer, a perder a sua integridade.33 Porém, no que concerne ao clima e à energia, os cientistas, de várias áreas, caem frequentemente naquilo que se pode chamar “simplificação climática”. E o que causa isto? Talvez a falta de conhecimento sobre o assunto, ou talvez o medo de falar contra os seus pares científicos. Ou talvez seja simples convicção no proclamado consenso, nascida mais de uma fé do que da evidência.

Quanto às ONGs, a imprensa tende a conferir-lhes uma posição de autoridade. Mas também estes são grupos de interesses, com as suas próprias agendas climáticas e energéticas. E são também atores poderosos, que mobilizam apoiantes, arrecadam dinheiro, realizam campanhas e alcançam poder político. Para muitos, a “crise climática” é a sua completa raison d’être. É claro que não há problema em ser-se ativista, e os esforços das ONGs tornaram o mundo melhor de incontáveis maneiras. Mas distorcer a ciência para seguir uma causa é indesculpável, particularmente com a cumplicidade dos cientistas que trabalham nos seus conselhos consultivos. Finalmente, com toda a distorção que ocorre a montante, não surpreende que o público tenha uma visão pseudocientífica. Deste modo, quem divulgue alguns aspetos menos conhecidos dos relatórios de avaliação é imediatamente rotulado de negacionista ou militante de direita, pois a crença nas alterações climáticas consolidou-se na opinião pública como a única posição politicamente correta.

Como restaurar a ciência

A principal proposta de Koonin para restaurar a credibilidade da ciência passa pela criação de uma “Equipa “Vermelha” (Red Team) que deveria ser encarregada de analisar os relatórios de avaliação, tentando identificar e avaliar os pontos fracos. Em contrapartida, outro grupo qualificado, digamos, a “Equipa Azul” (Blue Team), que seria, presumivelmente, constituída pelos próprios autores dos relatórios, teria oportunidade de rebater os pontos fracos encontrados pela Equipa Vermelha. É claro que o IPCC das Nações Unidas, bem como o governo dos Estados Unidos, consideram os seus relatórios incontestáveis, uma vez que são rigorosamente revistos por pares científicos, antes da publicação. Sendo assim, qual a necessidade de um outro nível de revisão? A resposta direta é que – tal como em capítulos precedentes deste artigo foi salientado – esses relatórios apresentam grandes falhas. E uma razão importante para essas falhas prende-se com a forma como os relatórios são revistos. A ciência é um corpo de conhecimento que cresce através de testes, degrau a degrau. Se cada passo for sólido, os investigadores podem alcançar rapidamente resultados espantosos, como o desenvolvimento de vacinas ou moderna tecnologia da informação.

Ao saber que um investigador produziu um novo conhecimento sólido, outros pesquisadores examinam, e muitas vezes desafiam, resultados de experiências ou observações, ou formulam novos modelos e teorias. Foram as medições feitas corretamente? Havia controlos adequados às experiências? São os resultados consistentes com o conhecimento prévio? Quais são as razões para um resultado inesperado? Respostas satisfatórias a questões como estas são indispensáveis para a aceitação de novos resultados no sempre crescente corpo do conhecimento científico. Koonin participou em muitas revisões de pares, ao longo da sua longa carreira científica de 45 anos, às vezes como autor, outras vezes como revisor, outras como árbitro, e umas poucas vezes como editor. O que ele nos diz é que a revisão por pares pode efetivamente melhorar a apresentação de um artigo científico e normalmente captar os erros mais notórios, mas está muito longe de ser perfeita, e não garante de forma alguma que o artigo publicado não contenha erros. Uma avaliação independente dos resultados por outros investigadores, que conduzam estudos alternativos, é uma garantia muito mais forte de que os resultados estão corretos.

Mas um relatório de avaliação não é um artigo de pesquisa – de facto, trata-se de um tipo de documento muito diverso, com um propósito muito diferente. Artigos em revistas científicas são escritos por especialistas para especialistas. Ao invés, os autores dos relatórios de avaliação devem avaliar as validade e importância de uma diversidade de artigos, e depois sintetizá-los num conjunto de declarações importantes, destinadas a não especialistas. Por isso, a “história” do relatório de avaliação importa, como importa a linguagem usada para contá-la – especialmente em algo tão importante como o clima. Os processos para construir e rever os relatórios de avaliação sobre ciência climática não promovem a objetividade. Os funcionários das agências científicas e ambientais do governo (que devem eles próprios ter um ponto de vista) nomeiam ou escolhem os autores, que não estão sujeitos a restrições devidas a conflitos de interesses. Quer dizer, um autor pode trabalhar para uma companhia petrolífera ou para uma ONG que promova a “ação climática”. Isto aumenta as hipóteses de a persuasão ser favorecida, em detrimento da informação.

Um grande número de revisores especializados e voluntários reveem o texto preliminar dos relatórios. Mas ao contrário da revisão por pares dos artigos científicos, os desacordos entre revisores e autores não são resolvidos por um árbitro independente; o autor principal pode optar pela rejeição de uma crítica dizendo, simplesmente, “não concordamos”. As versões finais das avaliações são então objeto da aprovação governamental (através de um processo entre agências para o governo dos Estados Unidos, e reuniões, muitas vezes contenciosas, entre especialistas e políticos, no caso do IPCC). E – um ponto muito importante – os “Resumos para Decisores Políticos” do IPCC são fortemente influenciados, se não mesmo escritos, por governos que têm interesse em promover políticas particulares. Em suma, há muitas oportunidades para corromper a objetividade do processo e da versão final. É por isso que uma Equipa Vermelha é tão necessária. Ela poderia constituir uma importante ferramenta para corrigir os erros no processamento dos relatórios de avaliação.